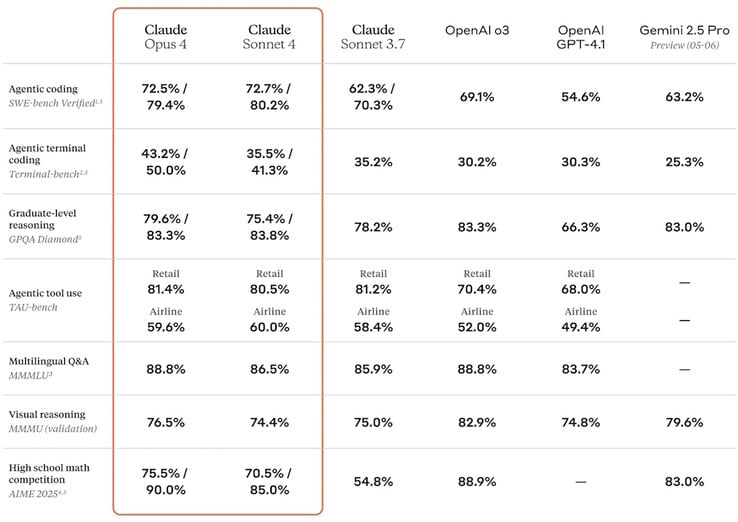

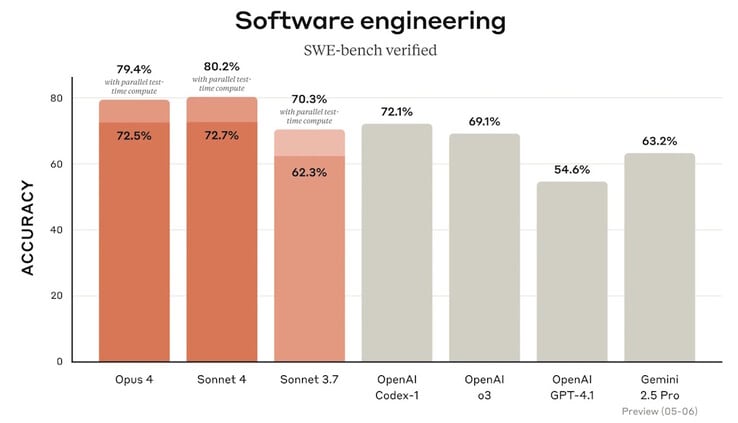

Anthropic a mis en vente le Claude Opus 4 et Claude Sonnet 4 modèles d'intelligence artificielle dont la précision, les capacités et les performances ont été améliorées.

Opus est le modèle le plus intelligent de l'entreprise, capable de travailler sur des problèmes complexes et difficiles pendant des heures sans interruption. Certains des premiers utilisateurs ont constaté qu'il travaillait de manière autonome sur des tâches de programmation pendant sept heures, et l'intelligence artificielle peut mieux mémoriser les entrées et les résultats pour améliorer les réponses. Sonnet est son modèle général pour des réponses rapides à des questions d'ordre général. Les deux modèles ont amélioré la précision du codage pour aider les programmeurs à créer les applications les plus récentes.

Les deux modèles peuvent agir en tant qu'analystes de données en écrivant du code Python pour analyser et visualiser des ensembles de données. Plusieurs nouvelles fonctions API permettent aux entreprises de créer des applications personnalisées qui intègrent Claude pour améliorer l'analyse des données commerciales et les fonctionnalités. Claude Code permet à l'IA de fonctionner dans des IDE populaires comme VS Code et JetBrains pour aider les programmeurs à mieux coder.

Anthropic a activé ses normes de déploiement et de sécurité AI Safety Level 3 (ASL-3) par précaution pour Claude Opus 4, car l'entreprise n'a pas encore exclu la possibilité que l'IA soit capable d'actes dangereux, comme d'être jailbreakée et utilisée pour créer des armes chimiques, biologiques, radiologiques et nucléaires (CBRN).

Les lecteurs qui souhaitent profiter des avantages de l'IA anthropique au travail peuvent utiliser Plaude Note ou Plaude NotePin pour résumer et transcrire automatiquement des cours et des réunions. Ceux qui travaillent à la maison peuvent discuter avec Claude après en téléchargeant l'application Anthropic pour les ordinateurs portables et les smartphones.

Source(s)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs