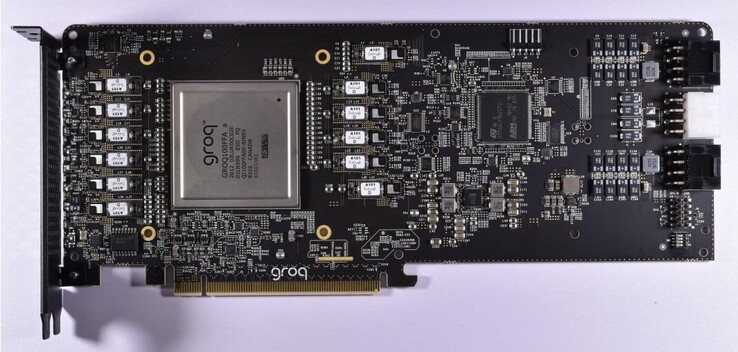

Alors que Nvidia réalise actuellement bénéfices exceptionnels en surfant sur la vague de l'IA grâce à la demande croissante de GPU de calcul, le marché pourrait devenir plus décentralisé à mesure que d'autres entreprises se lancent dans la fourniture de processeurs d'IA alternatifs viables. Nous avons constaté les efforts de plusieurs entreprises à cet égard, notamment AMD, d-Matrix, OpenAI et Samsung. Il semble que plusieurs ingénieurs ayant participé à la conception de l'unité de traitement tensoriel (TPU) de Google soient désormais impliqués dans des projets d'IA indépendants qui promettent de surpasser les solutions de Nvidia. Samsung, par exemple, a récemment annoncé que son nouveau laboratoire AGI Computing, ouvert dans la Silicon Valley, était dirigé par l'ancien développeur de la TPU de Google, le Dr Woo Dong-hyuk. Un autre ingénieur clé qui a contribué au développement de la TPU de Google est Jonathan Ross, aujourd'hui PDG d'une nouvelle entreprise appelée Groq. Grâce à l'expérience acquise chez Google, M. Ross apporte une innovation sur le marché des accélérateurs d'IA avec la première unité de traitement du langage (LPU) au monde.

La LPU de Groq est spécialement conçue pour traiter de grands modèles de langage (LLM) et présente des avantages indéniables par rapport aux GPU à usage général ou aux NPUs. Groq a initialement développé le Tensor Stream Processor (TSP), qui a ensuite été rebaptisé unité de traitement du langage pour refléter ses compétences accrues dans les tâches d'IA générative basées sur l'inférence. Étant donné qu'elle se concentre uniquement sur les LLM, la LPU est beaucoup plus rationalisée qu'une GPGPU et permet de simplifier le matériel d'ordonnancement avec une latence plus faible, un débit soutenu et une efficacité accrue.

Par conséquent, le LPU réduit le temps de calcul par mot et les séquences de texte peuvent être générées beaucoup plus rapidement. Une autre amélioration clé est que le LPU élimine le besoin de mémoire coûteuse (HBM), puisqu'elle n'utilise que 230 Mo de SRAM par puce avec une bande passante de 80 To/s, ce qui la rend considérablement plus rapide que les solutions GPGPU traditionnelles. L'architecture de Groq est également évolutive, car plusieurs LPU peuvent être interconnectées pour augmenter la puissance de traitement de LLM plus complexes.

Pour démontrer à quel point le moteur d'inférence LPU est plus rapide que les GPU, Groq propose une comparaison vidéo de son propre chatbot qui peut basculer entre les LLM Llama 2 / Mixtral et les LLM d'OpenAI Chat-GPT. Groq affirme que le LLM génère le texte en une fraction de seconde et que les 3 ⁄ 4 restants du temps sont consacrés à la recherche d'informations pertinentes.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs

![Lenovo lance l'ordinateur de jeu 2024 GeekPro (Source de l'image : Lenovo [Edited])](fileadmin/_processed_/b/f/csm_2024-Lenovo-GeekPro_ba34df66de.jpg)