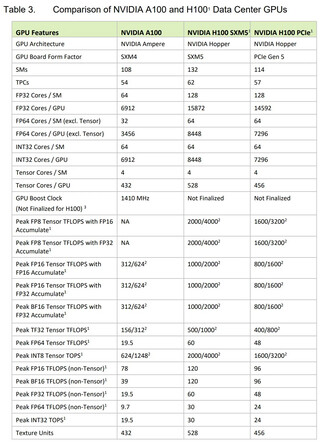

Les GPU Hopper H100 AI et HPC de Nvidia viennent d'être dévoilés à la GTC en même temps que les superpuces Grace. Comme toujours, les modèles de GPU de calcul sont hautement évolutifs, et Nvidia propose diverses solutions multi-GPU pour répondre aux différents besoins des centres de données. Un seul GPU Tensor Core H100, d'autre part, apporte des améliorations significatives par rapport à l'A100 2020 Ampère 2020 Ampère A100 notamment dans le domaine des opérations FP.

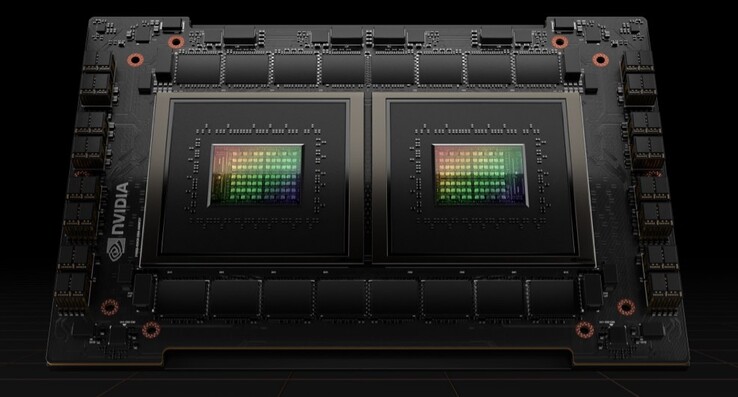

Tout d'abord, le GPU H100 est fabriqué sur des Nœuds de 4 nm de TSMC et possède un die de 814 mm² (14 mm² de moins que l'A100). Ce modèle est le premier de Nvidia à intégrer la technologie PCIe 5.0 et il existe également un facteur de forme SXM plus rapide. Le GPU lui-même comprend pas moins de 80 milliards de transistors, ce qui représente une augmentation de près de 50 % par rapport à l'Ampère. Il comporte également 132 clusters GPU avec 16896 cœurs CUDA pour la norme SXM et 14592 cœurs CUDA pour la norme PCIe 5.0, soit plus du double de la génération précédente

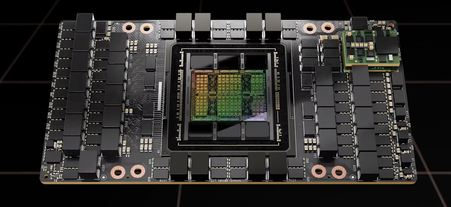

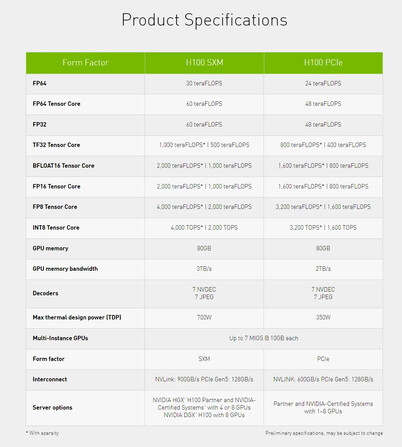

Le cache L2 passe de 40 à 50 Mo, mais le bus mémoire reste le même, à 5120 bits, et la capacité de mémoire est fixée à 80 Go HBM3 avec une bande passante de 3 ou 2 To/s selon le facteur de forme. La version SXM comporte 528 cœurs Tensor et nécessite 700 W, tandis que la version PCIe ne comporte que 456 cœurs Tensor et est limitée à 350 W TGP. Nvidia affirme que 20x les GPU H100 peuvent supporter l'équivalent du trafic Internet mondial, mais la nouvelle architecture peut être mise à l'échelle pour des centaines, voire des milliers de clusters DGX qui seront utilisés dans les futurs superordinateurs

En ce qui concerne les performances FP, le GPU H100 peut traiter 4 PFLOPS de FP8 (6x plus que A100), 2 PFLOPS de FP16 (3x plus que A100), 1 PFLOPS de TF32 (3x plus que A100) et 60 TFLOPS de FP64/FP32 (3x plus que A100). Des améliorations similaires peuvent être obtenues avec les calculs FP de Tensor Core.

Nvidia prévoit également de publier une version de la technologie Grace Hopper qui combine un GPU H100 et un CPU Grace connectés ensemble par un NVLink 900 GB/s. De même, il y aura également une super-puce Grace qui combine deux CPU Grace offrant 144 cœurs ARM, 1 TB/s LPDDR5x et 396 Mo de cache sur la puce. Cette super-puce Grace peut être associée à un maximum de huit GPU Hopper, mais de telles configurations ne seront pas disponibles avant le troisième trimestre 2023. Les GPU Hopper de Nvidia, quant à eux, seront livrés à partir du troisième trimestre 2022.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs