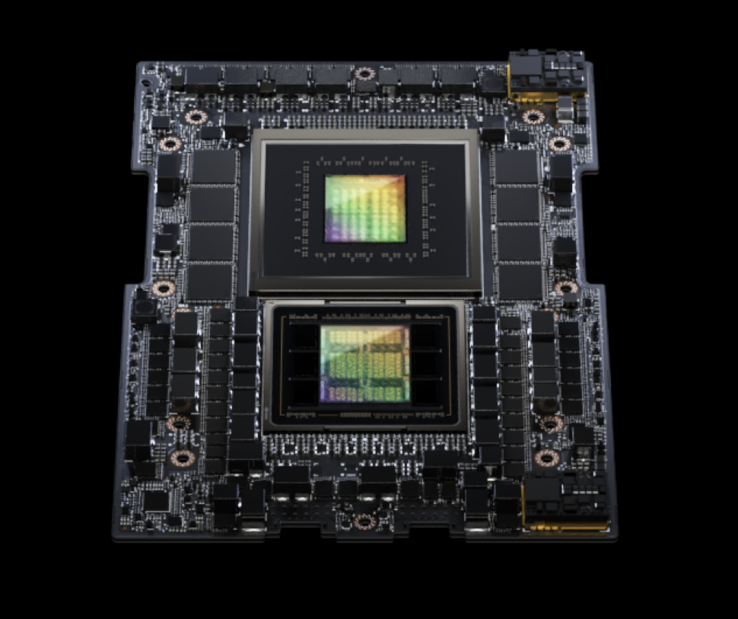

Nvidia a lancé son dernier Grace Hopper conçu pour alimenter les centres de données qui utilisent l'IA générative ou d'autres calculs accélérés. Bien que Nvidia continue de fabriquer des puces basées sur Arm pour les consommateurs sous différentes formes, elle a pivoté il y a quelques années pour donner la priorité aux SoC pour serveurs basés sur Arm qui peuvent être encore accélérés en intégrant sa plateforme Grace Hopper avec ses GPU de classe serveur. Le pari de la société s'est avéré payant à la suite de l'essor des technologies d'IA générative, notamment ChatGPT et Midjourney, ce qui a fait bondir le cours de son action d'environ 200 % depuis le début de l'année.

Comme pour la super-puce Grace Hopper originale, le nouveau GH200 en configuration double passe à 144 cœurs Arm V-series Neoverse. Comme auparavant, le processeur (Grace) est associé au GPU H100 Tensor Core (Hopper) de Nvidia. Les GPU H100 peuvent fournir un minimum de 51 téraflops de calcul FP32 et l'architecture GH200 combinée peut atteindre une performance impressionnante de 8 pétaflops en matière d'IA.

Pour atteindre ces nouveaux niveaux de performance avec le GH200 - bien que l'architecture du silicium reste inchangée - Nvidia a mis à niveau l'architecture de la mémoire avec 282 Go de la dernière mémoire HBM3e. La mémoire HBM3e est 50 % plus rapide que la mémoire HBM3 classique, avec une bande passante totale de 10 To/sec. Cela permet à la GH200 de traiter des modèles 3,5 fois plus grands que la puce de première génération et fait d'elle la première au monde à disposer de la mémoire HBM3e.

Nvidia indique également que la plate-forme Grace Hopper est évolutive et qu'elle permet de connecter des puces Grace Hopper supplémentaires à l'aide de l'interconnexion NVLink de Nvidia. La mémoire cohérente (partagée entre tous les CPU et GPU du cluster) peut atteindre 1,2 To. Nvidia indique que les principaux fabricants de serveurs devraient livrer des systèmes utilisant des configurations GH200 dans plus de 100 variantes de serveurs au deuxième trimestre 2024.

Lekit de développement Nvidia Jetson Nano AI est disponible sur Amazon au prix de 149 $.

Source(s)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs