Samsung livre la mémoire AI la plus chère jamais commandée par Nvidia, car la mémoire HBM4 dépasse les spécifications essentielles

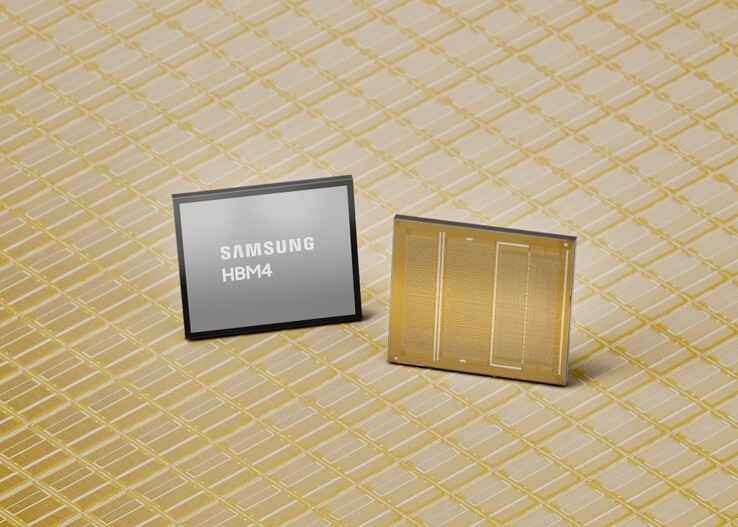

Samsung a annoncé les premières livraisons commerciales d'une mémoire HBM4 de nouvelle génération pour des applications telles que les GPU Nvidia et les centres de données d'IA respectifs.

Nvidia et d'autres clients auraient payé payer près de 500 dollars l'unité à Samsung, soit le double de ce qu'ils payaient pour la génération précédente de mémoire à large bande passante HBM3E. En conséquence, les actions de Samsung ont atteint un niveau record et la direction de l'entreprise s'attend à une nouvelle année record en profitant de la pénurie générale de mémoire mémoire.

Caractéristiques de la mémoire HBM4 de Samsung

Alors que les fabricants de mémoire font actuellement payer un bras et une jambe pour chaque unité qu'ils produisent, Samsung affirme que sa nouvelle mémoire HBM4 AI est parvenue à dépasser à la fois la norme du Joint Electron Device Engineering Council (JEDEC) et les exigences de Nvidia.

La vitesse de fonctionnement de la mémoire HBM4 peut atteindre 13 Gbps, soit 46 % de plus que les exigences du JEDEC, et la bande passante totale de la mémoire peut atteindre 3,3 TB/s par pile, ce qui dépasse largement les 3 TB/s demandés par des clients comme Nvidia.

Samsung a obtenu ce débit exceptionnel en appliquant de manière préventive le processus DRAM 1c de 6e génération en 10 nm avec la matrice de base fabriquée en 4 nm, par opposition à la DRAM 1a en 14 nm utilisée pour le prédécesseur de la mémoire HBM3. La génération de mémoire AI HBM4 dispose ainsi d'une grande marge de manœuvre pour améliorer le processus et les performances. Pour gérer toute la chaleur générée, Samsung a conçu le noyau et la transmission des données avec des technologies à faible consommation d'énergie et à faible tension pour une dissipation de la chaleur 30 % plus efficace et une efficacité énergétique 40 % plus élevée par rapport à la génération de mémoire HBM3 que Nvidia utilise actuellement dans ses cartes graphiques IA de la série Blackwell.

Pour l'instant, Samsung peut livrer aux clients une capacité maximale de 36 Go de mémoire HBM4 via une pile de 12 couches, mais elle peut également fabriquer une pile de 16 couches pour un total de 48 Go dès que Nvidia sera prête avec la conception et le pouvoir d'achat du GPU correspondant. Samsung promet suffisamment de puces HBM4 coûteuses, affirmant qu'il"continuera à garantir des capacités d'approvisionnement stables pour répondre à la demande croissante à moyen et long terme, en particulier de l'IA et des centres de données" lorsqu'il commencera à échantillonner sa mémoire HBM4E de nouvelle génération dans la seconde moitié de 2026.

Achetez le kit de mémoire Crucial DDR5 pour ordinateur portable de 64 Go sur Amazon

Source(s)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs