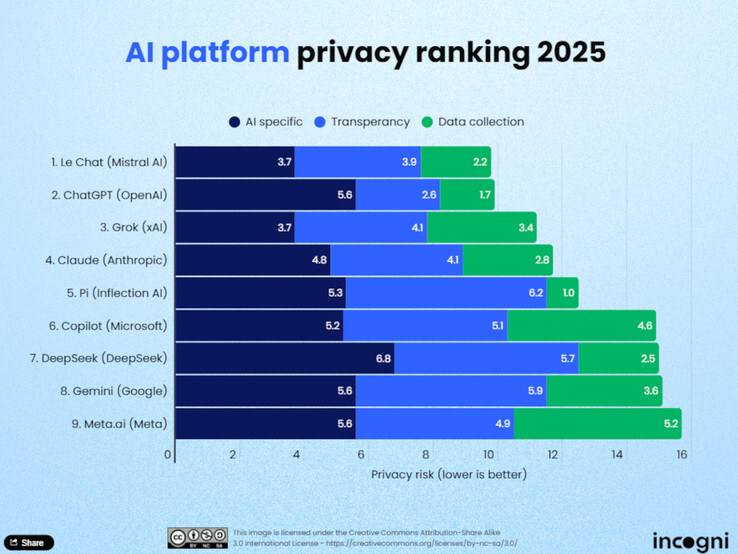

L'utilisation de l'intelligence artificielle (IA) dans la vie quotidienne augmente, et avec elle l'importance de la protection des données. Les analystes de la protection des données de Incogni ont récemment évalué neuf grands modèles de langage (LLM) afin de déterminer les plateformes qui respectent le plus la vie privée des utilisateurs. L'étude évalue les modèles d'IA sur la base de onze critères répartis en trois catégories principales : la collecte de données pour la formation, la transparence et l'utilisation et le partage des données.

Les meilleurs classements

Le Chat de Mistral AI est en tête du classement. Selon Incogni, le modèle recueille relativement peu de données sur les utilisateurs et offre une approche très économe en données, tant pendant la phase de formation qu'en fonctionnement réel. Le modèle ChatGPT d'OpenAI suit de près et se distingue surtout par sa transparence. Les utilisateurs peuvent spécifier dans leur compte si leurs conversations peuvent être utilisées pour développer le modèle, et si l'historique est désactivé, le stockage est empêché. Grok de xAI occupe la troisième place et impressionne également par la transparence de ses pratiques en matière de protection des données.

Les derniers du classement

Meta AI, Gemini de Google et Copilot de Microsoft occupent les dernières places du classement. Selon Incogni, ces plateformes collectent de nombreuses données sans offrir aux utilisateurs d'options de retrait claires. DeepSeek, un modèle chinois, obtient également de mauvais résultats. Ces fournisseurs n'offrent pas d'options claires pour exclure les données des utilisateurs de la formation.

Méthodologie

Les analystes d'Incogni ont évalué les plateformes sur la base de onze critères répartis en trois catégories : la collecte de données pour la formation, la transparence et l'utilisation et le partage des données. La catégorie "utilisation et partage des données" a compté pour 50 % de la note globale, tandis que la "transparence" a compté pour 30 % et les "données de formation" pour 20 %. Seuls quatre des neuf outils testés permettent aux utilisateurs d'exclure activement leurs données de la formation.

Conclusion

L'étude montre que la protection des données n'est pas encore une norme partout dans le monde de l'IA. Les utilisateurs devraient donc se familiariser activement avec les politiques de confidentialité des fournisseurs, en particulier lorsqu'il s'agit de contenus sensibles, d'informations confidentielles sur les clients ou de données personnelles. Ceux qui attachent de l'importance à la protection des données trouveront des options raisonnables dans Le Chat, ChatGPT ou Grok. Cependant, les LLM réellement efficaces en matière de données resteront l'exception en 2025

Source(s)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs