Microsoft a lancé Phi-3 en début de semaine sur HuggingFace, Ollama et le catalogue Azure AI. Bien qu'il ne soit pas tout à fait à la hauteur des compétences en matière de connaissances générales de Windows Copilotla technologie d'IA open-source représente la quatrième génération de petits modèles de langage de Redmond qui rivalisent avec les LLM classiques en termes de vitesse, d'efficacité et de performance.

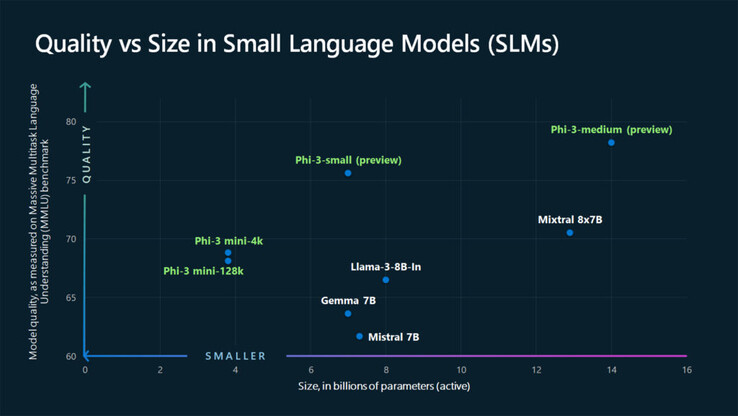

Avec 3,8 milliards de paramètres, Phi-3 est légèrement plus grand que son prédécesseur mais reste suffisamment petit pour fonctionner sur un espace de stockage mobile de 1,8 Go. À titre de comparaison, un LLM complexe typique tel que Llama ou GPT-3.5 utilise des centaines de milliards de paramètres pour comprendre les données d'entrée et il n'est pas pratique de le stocker en mode natif. GPT-5, lancé cet étéon s'attend à ce que la taille du GPT-5 atteigne des trillions de paramètres. Selon les lois d'échelle conventionnelles, plus de paramètres signifie plus de résultats intelligents. Mais selon Microsoft, ce n'est pas nécessairement le cas.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs

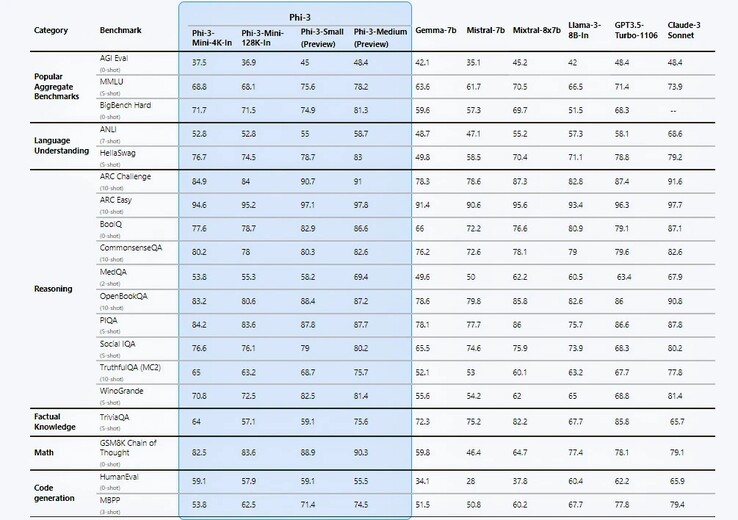

Microsoft fait des déclarations audacieuses dans son rapport technique https://arxiv.org/pdf/2404.14219; la principale étant les tests de performance qui sont, de l'aveu même de l'entreprise, purement théoriques. Dans 12 des 19 tests de référence, Phi-3-mini semble être plus performant que Llama-3-instruct, bien qu'il fonctionne avec plus de deux fois plus de paramètres. Avec le 7B Phi-3-small et le 14B Phi-3-medium, les résultats sont encore plus stupéfiants.

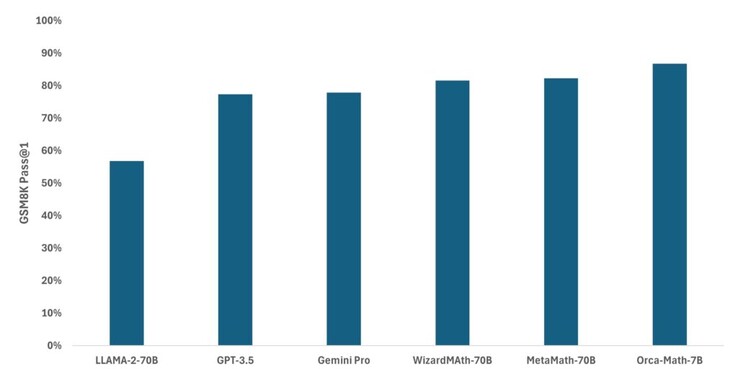

Les ingénieurs attribuent ces gains d'efficacité à leur ensemble de données d'entraînement soigneusement sélectionnées de données d'entraînement soigneusement sélectionnées, provenant de deux sources : un contenu web de qualité "manuel" et des données générées par l'IA, conçues pour enseigner le langage, les connaissances générales et le raisonnement de bon sens, avec une liste de 3 000 mots triés sur le volet qui servent d'éléments de base. Les chercheurs de Microsoft affirment que ce type de recette de données a permis au Phi-2 de l'année dernière d'égaler les performances du modèle Llama-2 de Meta, considérablement plus grand (70 B) Modèle Llama-2 de Meta, considérablement plus grand (70 B).

Eric Boyd, vice-président d'Azure AI, se vante auprès de The Verge que Phi-3 est tout aussi capable que GPT-3.5, bien que dans un "facteur de forme plus petit". Cependant, Phi-3 continue d'être affecté par un manque de connaissances factuelles en raison de sa taille limitée. Peut-être s'agit-il d'un compromis nécessaire pour que l'IA fonctionne de manière native plutôt que via le cloud computing ?

Étant donné que la flexibilité et la rentabilité sont des éléments clés pour les entreprises, il n'est pas surprenant que celles-ci aient déjà commencé à exploiter les capacités des SLM. Cependant, le Phi-3 a une concurrence féroce. Meta's Llama-3de Meta, Claude-3 suite d'Anthropicd'Anthropic, Google Gemini et Gemma ont tous des versions légères capables de prendre en charge l'informatique de pointe sur mobile. Et bien que Phi-3 semble rivaliser favorablement, Gemini Nano est déjà arrivé sur des appareils tels que le Google Pixel 8 Pro et la série Samsung Galaxy S24(784 $ sur Amazon).

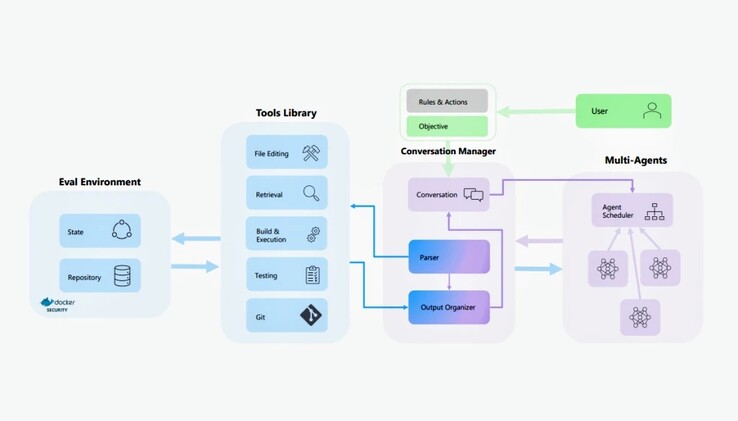

La famille de modèles d'IA Phi-3 est loin d'être le seul SLM sur lequel Microsoft a travaillé. Le mois dernier, la société a adapté Mistral pour créer Orca-Mathun modèle spécialisé qui s'est avéré beaucoup plus précis que Llama, GPT-3.5 et Gemini Pro pour les mathématiques de l'école primaire. AutoDevun projet plus récent, s'appuie sur AutoGen et Auto-GPT pour planifier et exécuter de manière autonome des tâches de programmation en fonction d'objectifs définis par l'utilisateur. Les guerres de l'IA sont loin d'être terminées, mais au moins à l'échelle inférieure, nous avons un concurrent de premier plan.

![Microsoft souhaite savoir si vous envisagez d'acquérir un nouvel ordinateur de poche de jeu dans les cinq prochaines années (Source de l'image : Logitech [édité])](fileadmin/_processed_/a/0/csm_Logitech-G-Cloud_f62f43f9e7.jpg)