La semaine dernière, des chercheurs de Apple ont présenté OpenELM, une série de " modèles de langage efficacesopen-source", sur la bibliothèque de modèles Hugging Face. Les quatre variantes varient en taille de 270 millions de paramètres à 3 milliards, et sont les candidats les plus probables pour l'IA sur les appareils Apple.

Pour situer le contexte, Apple a lancé discrètement un cadre d'apprentissage automatique appelé MLX en décembre 2023. L'étape suivante était MLLM-Guided Image Editing (MGIE) (Édition d'images guidée par MLLM)suivi d'une succession d'efforts en matière d'IA générative, notamment Keyframer, Ferret-UI et AI code-completion in Xcode. Pour la plupart, ces projets exploitent la puissance de traitement du silicium de Apple plutôt que de décharger la fonctionnalité d'IA dans le nuage.

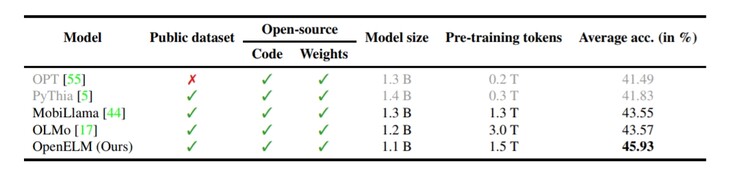

Dans le même ordre d'idées, OpenELM représente l'approche de Apple en matière d'IA sur l'appareil. En règle générale, les LLM publics utilisent des centaines de milliards (parfois des trillions) de variables pour comprendre les données de l'utilisateur et décider d'une réponse appropriée. En revanche, les modèles de langage plus petits, tels que Phi-3 de Microsoft, n'utilisent que 3,8 milliards de paramètres, tandis que Google Gemma peut se vanter d'en avoir 2 milliards. Cependant, grâce à l'approche unique d'OpenELM en matière d'architecture du modèle de transformateur, le modèle n'utilise que 270 millions de paramètres.

Évidemment, la petite taille présente des inconvénients. Tout d'abord, OpenELM n' est pas multimodal, car il a trop peu de paramètres pour que cela soit faisable. D'autre part, ses connaissances factuelles sont assez faibles, comme le montre le rapport technique https://www.google.com/url?sa=t&source=web&rct=j&opi=89978449&url=https://arxiv.org/abs/2404.14619&ved=2ahUKEwjthIWbmeyFAxXMXEEAHeVICrgQFnoECBQQAQ&usg=AOvVaw0lkrTbxKNgbdUB4po5zOEa . Ce problème concerne tous les LLM publics de taille similaire. Cependant, sa petite taille permet au modèle d'IA d'être hébergé localement sur des téléphones ou des ordinateurs portables au lieu d'être hébergé dans le nuage.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs

Applela publication d'OpenELM par la société s'écarte de ses pratiques habituelles. Du cadre complet et de l'évaluation du modèle aux journaux d'entraînement, en passant par les configurations de pré-entraînement et le code d'inférence MLX, chaque aspect du modèle de langage est publiquement disponible via Hugging Face pour que les développeurs puissent le modifier et l'adapter à différents cas d'utilisation. Apparemment, une version aussi complète devrait renforcer l'intérêt de Apple pour l'IA en incitant les chercheurs à explorer les possibilités offertes par les appareils Apple.

Mais il y a d'autres acteurs dans ce domaine. Le Phi-3 de Microsoft est un rival très compétent, tout comme les autres projets LLM ouverts de Redmond. Le Gemma 2B - 3B de Google en est un autre. Bien que tous les modèles susmentionnés fonctionnent encore trop lentement, le matériel et les logiciels évoluent certainement dans la bonne direction pour les petits modèles linguistiques.

Pour l'instant, les appareils de pointe tels que le Samsung Galaxy S24 (à partir de 799 $ sur Amazon), ou le OnePlus 12R utilisant la technologie interne Andes-GPT doivent s'appuyer sur le traitement en nuage. Que Apple intègre ou non OpenELM dans le prochain iPhone, il est probable que la société basée à Cupertino collabore avec Google ou Open AI pour des fonctions d'IA générative plus lourdes.