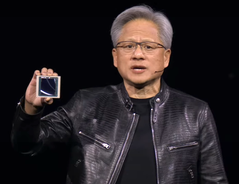

Huang, PDG de Nvidia, dévoile les derniers produits d'IA pour les entreprises ainsi que les avancées en matière de véhicules autonomes et de robots humanoïdes lors de la keynote de la GTC 2024

Nvidia Le PDG Jensen Huang a révélé les derniers produits et services d'IA de l'entreprise lors de la keynote à GTC 2024 le 18 mars 2024 à San Jose, en Californie. Destinées aux entreprises, les nouvelles offres de Nvidia promettent d'accélérer considérablement l'apprentissage de l'IA et son application à de nombreux domaines tels que la robotique, les prévisions météorologiques, la découverte de médicaments et l'automatisation des entrepôts. Le GPU Nvidia Blackwell, les NIM, le NEMO et la fonderie d'IA figurent parmi les offres notables dévoilées.

Le processus d'apprentissage de l'IA est beaucoup plus gourmand en ressources informatiques que l'utilisation d'un modèle d'IA, car des millions de documents d'entrée doivent être traités. Cela peut prendre des semaines, voire des mois, sur les superordinateurs les plus rapides disponibles aujourd'hui pour des entreprises comme Microsoft. Nvidia a déjà lancé la plateforme GPU Hopper en 2022 pour gérer des charges de calcul aussi importantes.

Lors de la GTC 2024, Huang a dévoilé Blackwell, la suite de Hopper, disponible sous forme de carte de remplacement pour les installations Hopper actuelles. Le GPU Blackwell se compose de deux matrices GPU à 104 milliards de transistors sur un processus TSMC 4NP (probablement N4P, typo) (probablement N4P, faute de frappe dans la présentation) pour 20 pétaflops FP4 avec 192 Go de mémoire HBM3e capable de transférer 8 To/s. En comparaison, un 4090 DE BUREAU dispose d'un seul GPU de 76,3 milliards de transistors, d'un processus de 5NM, d'une performance de 1,32 Tensor FP8 pétaflops avec 24 Go de mémoire GDDR6X. Si l'on double le chiffre de 4090 FP8 pour l'ajuster à 4 bits, on obtient environ 20 pétaflops Blackwell contre 3 pétaflops 4090.

Lorsque 72 GPU Blackwell sont placés dans une seule armoire DGX GB200 NVL72 associés à un refroidissement liquide, à des CPU NVLink améliorés et à d'autres améliorations en matière d'interconnexion, les performances sont nettement meilleureset d'autres améliorations de l'interconnexion, les performances par rapport aux armoires Hopper sont multipliées par 22 pour l'entraînement FP8 AI et par 45 pour l'inférence FP4 AI. La consommation d'énergie pour l'entraînement à l'IA de Blackwell est également réduite d'environ 4 fois par rapport à Hopper.

Modèles d'IA préemballés du NIMS

Pour tirer parti de ce bond en avant des performances, Nvidia a introduit des modèles d'IA prépackagés appelés NIMS (Nvidia Inference Microservice)utilisant Kubernetes pour fonctionner sur les GPU Nvidia CUDA localement ou sur le cloud. L'accès au NIMS autonome se fait par le biais d'une API HUMAN simplifiée. L'objectif est de créer un avenir où les services d'IA sont créés en demandant à une IA de créer une application avec certaines fonctionnalités, puis l'IA mélange et associe différents NIMS sans nécessiter de programmation de bas niveau. Enfin, pour faciliter la formation des NIMS, Nvidia a présenté NeMO Microservices pour personnaliser, évaluer et sécuriser le processus de formation sur les documents de l'entreprise.

Nvidia BioNeMO et le NIMS biologique

Huang a annoncé que Nvidia développera des NIMS formés sur des données biologiques et médicales afin de fournir aux chercheurs un accès plus facile à l'IA qui peut améliorer tous les aspects de la médecine, par exemple en trouvant plus rapidement des candidats médicaments.

Thor ASIL-D et véhicules électriques autonomes BYD

M. Huang a déclaré que BYD sera le tout premier constructeur de véhicules électriques au monde à adopter son nouvel ordinateur Thor ASIL-D ( ) qui utilise un SoC d'IA pour traiter les données visuelles et de conduite afin d'assurer une grande sécurité dans la conduite autonome. Si l'on ajoute à cela l'annonce récente de SuperDrive by Plus sur https://plus.ai/news-and-insights/plus-advances-the-development-of-next-generation-vision-models-built-on-nvidia-drive-for-ai-processing-in-its-self-driving-softwarebYD sera l'une des premières entreprises automobiles à commercialiser un véhicule électrique autonome de niveau 4 ( ) autonome de niveau 4.

Projet Groot de Nvidia robots humanoïdes

M. Huang a encore démontré les progrès réalisés dans le domaine de la robotique en présentant les capacités de ses robots, qui sont d'abord entraînés dans l'univers Omniverse comme un jumeau numérique, puis ils sont autorisés à accomplir des tâches dans des corps robotiques réels. Des démonstrations de cuisson, de rotation de bâtons avec les doigts, de tri et d'assemblage de produits et de navigation autour d'obstacles ont été présentées. Pour atteindre ce niveau de robotique, l'IA Nvidia Project Groot A été créée en l'entraînant d'abord à partir de textes, de vidéos et de démonstrations, puis en l'affinant grâce à des observations réelles de tâches effectuées. Associé au même ordinateur Thor que celui utilisé dans les véhicules et Nvidia Tokkio AI les robots de démonstration ont été capables d'observer les actions effectuées par les humains, puis de les reproduire pour préparer des boissons, jouer de la batterie et répondre à des demandes vocales.

Nvidia Omniverse Cloud ajoute la prise en charge de Apple Vision Pro

M. Huang a déclaré que le site Nvidia Omniverse Cloud est désormais compatible avec le système Apple Vision Pro en plus du casque Meta Quest et HTC Vive Prola carte graphique Nvidia est clairement destinée aux développeurs qui utilisent les GPU Nvidia dans le nuage, car aucun Macintosh ne dispose d'un GPU Nvidia compatible.

Les lecteurs qui souhaitent participer à la révolution de l'IA auront besoin d'une carte graphique Nvidia puissante(comme celle-ci chez Amazon) pour développer des compétences et des applications dans le domaine de l'IA.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs

NVIDIA lance le DGX SuperPOD alimenté par Blackwell pour le supercalcul de l'IA générative à l'échelle du trillion de paramètres

Le DGX SuperPOD passe à des dizaines de milliers de superpuces Grace Blackwell en utilisant les réseaux les plus avancés de NVIDIA, les logiciels d'IA complets de NVIDIA et le stockage. Il comprend jusqu'à 576 GPU Blackwell connectés en une seule unité avec NVIDIALink. Les experts système de NVIDIA accélèrent le déploiement d'une infrastructure d'IA immédiate

18 mars 2024

gTC-NVIDIA annonce aujourd'hui son supercalculateur d'IA de nouvelle génération - le NVIDIA DGX SuperPOD™ équipé de superpuces NVIDIA GB200 Grace Blackwell - pour traiter des modèles à mille milliards de paramètres avec un temps de disponibilité constant pour des charges de travail de formation et d'inférence d'IA générative à très grande échelle.

Doté d'une nouvelle architecture à l'échelle du rack, très efficace et refroidie par liquide, le nouveau DGX SuperPOD est construit avec des systèmes NVIDIA DGX™ GB200 et fournit 11,5 exaflops de supercalculateur d'IA à la précision FP4 et 240 téraoctets de mémoire rapide - évoluant vers plus avec des racks supplémentaires.

Chaque système DGX GB200 comporte 36 superchips NVIDIA GB200 - qui comprennent 36 CPU NVIDIA Grace et 72 GPU NVIDIA Blackwell - connectés comme un seul supercalculateur via NVIDIA NVLink® de cinquième génération. Les Superchips GB200 multiplient par 30 les performances par rapport au GPU NVIDIA H100 Tensor Core pour les charges de travail d'inférence de grands modèles de langage.

"Les supercalculateurs NVIDIA DGX AI sont les usines de la révolution industrielle de l'IA ", a déclaré Jensen Huang, fondateur et CEO de NVIDIA. "Le nouveau DGX SuperPOD associe les dernières avancées en matière d'informatique accélérée, de réseaux et de logiciels NVIDIA pour permettre à chaque entreprise, industrie et pays d'affiner et de générer sa propre IA

Le DGX SuperPOD alimenté par Grace Blackwell comprend huit systèmes DGX GB200 ou plus et peut évoluer jusqu'à des dizaines de milliers de Superchips GB200 connectés via NVIDIA Quantum InfiniBand. Pour disposer d'un espace mémoire partagé massif afin d'alimenter les modèles d'IA de la prochaine génération, les clients peuvent déployer une configuration qui connecte les 576 GPU Blackwell dans huit systèmes DGX GB200 connectés via NVLink.

Nouvelle architecture DGX SuperPOD à l'échelle du rack pour l'ère de l'IA générative

Le nouveau DGX SuperPOD avec les systèmes DGX GB200 dispose d'une structure de calcul unifiée. En plus de NVIDIA NVLink de cinquième génération, la structure comprend des DPU NVIDIA BlueField®-3 et supportera le réseau InfiniBand NVIDIA Quantum-X800, annoncé séparément aujourd'hui. Cette architecture fournit jusqu'à 1 800 gigaoctets par seconde de bande passante à chaque GPU de la plate-forme.

De plus, la technologie NVIDIA Scalable Hierarchical Aggregation and Reduction Protocol (SHARP)™ de quatrième génération fournit 14,4 téraflops de calcul en réseau, soit une augmentation de 4 fois dans l'architecture DGX SuperPOD de nouvelle génération par rapport à la génération précédente.

L'architecture clé en main s'associe à un logiciel avancé pour un temps de disponibilité sans précédent

Le nouveau DGX SuperPOD est un supercalculateur d'IA complet à l'échelle du centre de données qui s'intègre au stockage haute performance des partenaires certifiés par NVIDIA pour répondre aux exigences des charges de travail d'IA générative. Chacun est construit, câblé et testé en usine pour accélérer considérablement le déploiement dans les centres de données des clients.

Le DGX SuperPOD alimenté par Grace Blackwell est doté de capacités de gestion prédictive intelligente pour surveiller en permanence des milliers de points de données à travers le matériel et le logiciel afin de prédire et d'intercepter les sources de temps d'arrêt et d'inefficacité, ce qui permet d'économiser du temps, de l'énergie et des coûts informatiques.

Le logiciel peut identifier les zones de préoccupation et planifier la maintenance, ajuster de manière flexible les ressources de calcul, et sauvegarder et reprendre automatiquement les travaux pour éviter les temps d'arrêt, même en l'absence d'administrateurs système.

Si le logiciel détecte qu'un composant doit être remplacé, la grappe activera la capacité de réserve afin que le travail soit terminé à temps. Tout remplacement de matériel nécessaire peut être planifié afin d'éviter les temps d'arrêt non planifiés.

Les systèmes NVIDIA DGX B200 font progresser le supercalculateur d'IA pour les industries

NVIDIA a également dévoilé le système NVIDIA DGX B200, une plate-forme unifiée de supercalculateur d'IA pour la formation, l'ajustement et l'inférence de modèles d'IA.

Le DGX B200 est la sixième génération de DGX refroidis par air et montés en rack traditionnels utilisés par les industries du monde entier. Le nouveau système DGX B200 à architecture Blackwell comprend huit GPU NVIDIA Blackwell et deux processeurs Intel® Xeon® de 5e génération. Les clients peuvent également construire des DGX SuperPOD en utilisant des systèmes DGX B200 pour créer des centres d'excellence en IA qui peuvent alimenter le travail de grandes équipes de développeurs exécutant de nombreux travaux différents.

Les systèmes DGX B200 intègrent la fonction de précision FP4 dans la nouvelle architecture Blackwell, offrant jusqu'à 144 pétaflops de performance IA, une énorme mémoire GPU de 1,4 To et une bande passante mémoire de 64 To/s. Ces systèmes offrent une inférence en temps réel 15 fois plus rapide que les autres systèmes d'IA. Cela permet une inférence en temps réel 15 fois plus rapide pour les modèles à mille milliards de paramètres par rapport à la génération précédente.

Les systèmes DGX B200 intègrent une mise en réseau avancée avec huit NIC NVIDIA ConnectX™-7 et deux DPU BlueField-3. Ceux-ci fournissent jusqu'à 400 gigabits par seconde de bande passante par connexion - pour des performances d'IA rapides avec les plateformes de mise en réseau NVIDIA Quantum-2 InfiniBand et NVIDIA Spectrum™-X Ethernet.

Logiciel et support d'experts pour faire évoluer l'IA de production

Toutes les plateformes NVIDIA DGX incluent le logiciel NVIDIA AI Enterprise pour le développement et le déploiement à l'échelle de l'entreprise. Les clients DGX peuvent accélérer leur travail avec les modèles de fondation NVIDIA préformés, les frameworks, les boîtes à outils et les nouveaux microservices NVIDIA NIM inclus dans la plateforme logicielle.

Lesexperts NVIDIA DGX et certains partenaires NVIDIA certifiés pour les plates-formes DGX assistent les clients à chaque étape du déploiement, afin qu'ils puissent rapidement mettre l'IA en production. Une fois que les systèmes sont opérationnels, les experts DGX continuent d'aider les clients à optimiser leurs pipelines et leur infrastructure d'IA.

Disponibilité

Le NVIDIA DGX SuperPOD avec les systèmes DGX GB200 et DGX B200 devrait être disponible dans le courant de l'année auprès des partenaires de NVIDIA.

Pour plus d'informations, regardez le replay de la keynote de la GTC ou visitez le stand de NVIDIA à la GTC, qui se tient au San Jose Convention Center jusqu'au 21 mars.