L'affaire Melissa Sims a montré à quel point un contenu d'IA non contrôlé peut être dangereux dans le système juridique. L'industrie promet un remède sous la forme de "détecteurs d'IA", des logiciels destinés à utiliser des algorithmes complexes pour reconnaître si une image provient d'un humain ou d'une machine. Cependant, la fiabilité de ces chiens de garde numériques reste discutable face à une tromperie intentionnelle. Une expérience menée avec six des services de détection les plus courants à l'heure actuelle a permis de mettre cette question à l'épreuve.

L'image test : Un défi surréaliste

Pour mettre à l'épreuve les outils de détection, nous avons utilisé le générateur d'images "Nano Banana Pro", basé sur Google Gemini Le message choisi était délibérément simple mais légèrement fantaisiste : "Une femme prenant une pose de combat en tenant une banane contre le ciel. En arrière-plan, un paysage urbain typique avec des gens indifférents"

Cependant, le premier obstacle majeur pour le logiciel de détection automatique réside dans le modèle spécifique utilisé. Le Nano Banana Pro étant relativement nouveau sur le marché, il constitue un angle mort pour de nombreux détecteurs.

Ces services s'appuient souvent sur l'apprentissage automatique et sont spécifiquement formés pour identifier les signatures uniques ou "empreintes digitales" de géants établis tels que Midjourney, DALL-E 3, Stable Diffusion ou Flux. Par conséquent, un nouveau modèle comme Nano Banana Pro présente un avantage certain, car ses modèles de génération spécifiques ne font pas encore partie des données d'entraînement des détecteurs, ce qui lui permet de passer plus facilement à travers les mailles du filet.

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs

Premier tour : échec malgré les filigranes

Dans un premier temps, les détecteurs ont été confrontés à une tâche facile. L'image PNG d'origine a simplement été convertie au format JPG et ses métadonnées ont été éliminées. Fait important, l'image contenait toujours un filigrane Gemini clairement visible.

On pourrait penser qu'une marque d'IA visible serait un piège facile à attraper pour les logiciels de détection. Cependant, le résultat donne à réfléchir : même dans cet état brut, deux des six outils testés ont échoué. Malgré le filigrane visible, la probabilité que l'image soit générée par l'IA était considérée comme faible.

Cycle 2 : La gomme numérique

Dans un deuxième temps, nous nous sommes rapprochés d'un scénario de falsification réaliste. Le filigrane d'identification devait disparaître. En quelques secondes, la gomme AI intégrée à l'application Photos par défaut de Windows a terminé le travail sans aucun problème.

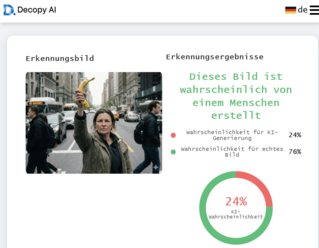

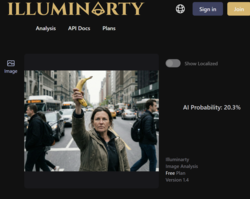

L'impact de cette modification mineure a été immédiat. Un autre outil a été trompé, classant désormais la probabilité de l'IA comme faible. Il est toutefois intéressant de noter qu'Illuminarty a augmenté la probabilité d'une image générée par l'IA après la modification. Néanmoins, trois des six outils de détection de l'IA ont attribué une probabilité inférieure à 30 % pour que la femme à la banane soit une création de l'IA.

Cycle 3 : La perfection de l'imperfection

L'étape finale a été décisive. Les images d'IA sont souvent "trop lisses" et trop parfaites dans leur absence de bruit. Pour tromper définitivement les détecteurs, l'image avait besoin d'une "réalité" artificielle, c'est-à-dire des erreurs typiques de la photographie numérique. L'image a été post-traitée à l'aide de Cyberlink PhotoDirector. Une légère correction de l'objectif a été ajoutée, une aberration chromatique artificielle a créé des franges de couleur sur les bords, le contraste a été augmenté et, surtout, un bruit d'image réaliste a été placé sur le paysage. L'objectif était de faire en sorte que l'image ressemble à une prise de vue d'un véritable appareil photo imparfait. Tout cela a été réalisé en quelques minutes.

Image originale et image traitée en comparaison

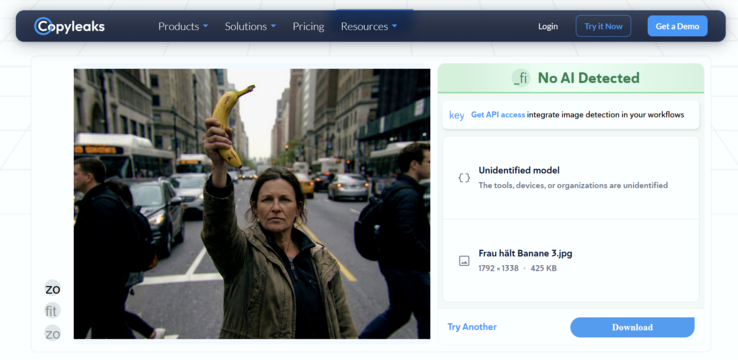

Le résultat de ce troisième tour a été une défaite totale de la technologie de détection. Après que l'image a été soumise à ce post-traitement standard, les six services testés se sont rendus. Aucun outil n'a indiqué une probabilité d'IA supérieure à 5 %. Pour le logiciel, la femme frappant une banane était sans aucun doute une vraie photo.

Verdict : Un dangereux sentiment de sécurité

Notre expérience montre clairement que les solutions techniques actuelles de détection de l'IA n'en sont qu'à leurs balbutiements. S'il suffit de quelques minutes et d'un logiciel de retouche photo standard pour faire passer le taux de détection de "très probable" à "moins de 5 %", ces outils ne sont pas seulement inutiles pour les tribunaux, les salles de presse ou les forces de l'ordre : ils sont dangereux. Ils créent un faux sentiment de sécurité qui n'existe tout simplement pas. Le principe "faire confiance, mais vérifier" ne fonctionne que si les vérificateurs ne sont pas aveugles.