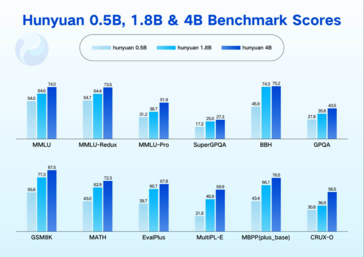

Tencent a publié sur une nouvelle série de modèles compacts Hunyuan une nouvelle série de modèles Hunyuan compacts : 0.5 milliards, 1,8 milliard, 4 milliards et 7 milliards de paramètres ; ils sont destinés aux déploiements à faible consommation d'énergie et en périphérie. Les quatre configurations sont désormais disponibles sur GitHub et Hugging Face, et chacune d'entre elles peut exécuter l'inférence sur une seule carte graphique grand public, ce qui les rend adaptées aux ordinateurs portables, aux smartphones, aux systèmes de cabine intelligente et à d'autres matériels à ressources limitées.

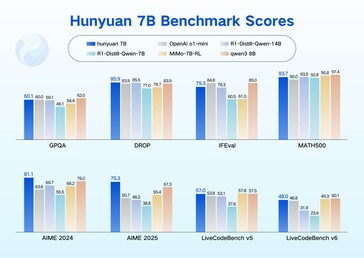

Malgré leur petite taille, les modèles obtiennent les meilleurs résultats en compréhension du langage, en mathématiques et en raisonnement dans plusieurs tests de référence publics. Tencent attribue ces résultats à une architecture de "raisonnement par fusion" qui permet aux utilisateurs de choisir entre un mode de réflexion rapide pour des réponses concises et un mode de réflexion lente pour un raisonnement plus élaboré en plusieurs étapes.

L'une des principales caractéristiques techniques est la fenêtre contextuelle native de 256 000 jetons, qui permet d'ingérer environ 500 000 mots anglais en une seule fois. Tencent met en avant des applications internes telles que Tencent Meeting et WeChat Reading, où les modèles peuvent analyser une transcription de réunion entière ou un livre complet en une seule fois, en conservant les relations entre les personnages et les détails de l'intrigue pour les requêtes ultérieures.

Les quatre LLM compacts s'intègrent aux cadres d'inférence courants, notamment SGLang, vLLM et TensorRT-LLM, et prennent en charge plusieurs formats de quantification. Les premiers soutiens d'Arm, Qualcomm, Intel et MediaTek indiquent que des packages de déploiement optimisés pour leurs processeurs clients respectifs seront bientôt disponibles.

Les premiers cas d'utilisation soulignent l'aspect pratique de cette version. Tencent Mobile Manager fait état d'une interception de spam au niveau de la milliseconde sans transfert de données hors de l'appareil. Dans le même temps, un schéma à double modèle dans l'assistant de cabine intelligent de Tencent permet d'équilibrer la consommation d'énergie à bord et la profondeur de la conversation. Selon Tencent, ces exemples démontrent que de petits modèles peuvent offrir des capacités d'agent de niveau entreprise lorsqu'ils sont conçus de manière réfléchie.

Source(s)

Technologie rapide (en chinois)

Top 10

» Le Top 10 des PC portables multimédia

» Le Top 10 des PC portables de jeu

» Le Top 10 des PC portables de jeu légers

» Le Top 10 des ordinateurs portables bureautiques

» Le Top 10 des PC portables bureautiques premium/professionnels

» Le Top 10 des Stations de travail mobiles

» Le Top 10 des Ultraportables

» Le Top 10 des Ultrabooks

» Le Top 10 des Convertibles

» Le Top 10 des Tablettes

» Le Top 10 des Tablettes Windows

» Le Top 10 des Smartphones

» Le Top 10 des PC Portables á moins de 300 euros

» Le Top 10 des PC Portables á moins de 500 euros

» Le Top 25 des meilleurs écrans d'ordinateurs